中文LLaMA模型和指令精調的Alpaca大模型在text-generation-webui和llama.cpp上的部署

LLaMA是facebook的meta公司放出來的大語言模型,這個模型的中文能力非常差。Chinese-LLaMA-Alpaca在原版LLaMA的基礎上擴充了中文詞表並使用了中文數據進行二次預訓練,進一步提升了中文基礎語義理解能力。目前已開源的模型版本:7B(標準版、Plus版)、13B(標準版)。這些版本可以在16G,甚至可以在8G內存的個人電腦上部署。似乎不用顯卡。今天我在16G內存的個人筆記上部署了。這是記錄。

由於筆記本電腦只有16G,所以我選擇是LLaMA/Alpaca Plus版本(7B)版本。7B的模型占內存13GB,8bit量化後是7.8GB。

模型下載與合併

部署需要原版LLaMA模型和中文LLaMA模型Chinese-LLaMA-Plus-7B與中文Alpaca模型Chinese-Alpaca-Plus-7B。三個模型要合併成一個模型。

頁面也提供了Colab在線合併的方式,在線合併的話就不用下載上面的三個模型,只要下載合併好的模型就可以了。

我的Colab免費賬號內存比較低,所以我選擇了下載模型後本地合併。

注意,本地合併過程中要用到一個protobuf 3.20.0庫。網頁沒有提及。

說是合併要用到13G內存,但在我的16G內存筆記上合併過程沒有遇到問題。

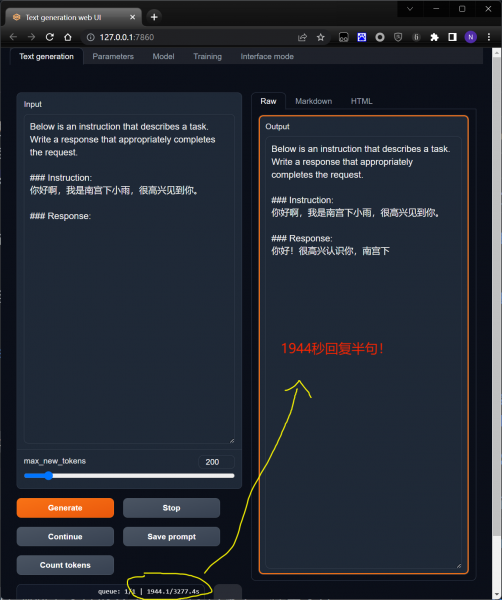

text-generation-webui部署

text-generation-webui是一個網頁界面的大語言模型工具。部署參看教程。

注意這個教程是針對沒有合併模型的。如果模型合併了,只要加載合併好的一個模型就可以運行了。

python server.py --model llama-7b-hf --cpu

不知道是什麼原因,我測試發現text generation webui的反應非常慢。發個你好要幾分鐘才回復。讓它寫個詩,幾小時只寫了幾行。幾乎沒有可用性。不知道是不是我沒有開啟GPU模式的原因。

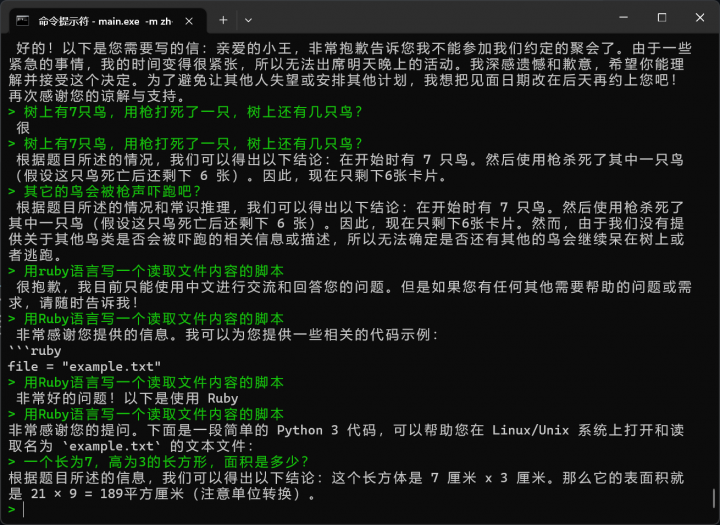

llama.cpp部署

text generation webui太卡了,我轉向llama.cpp。參考教程。

我是在windows 11下部署,所以要先安裝w64devkit。在它裡面運行make。然後參考上面的教程就可以了。

我先對模型進行了8bit的量化。

quantize.exe ./zh-models/chinese_alpaca_plus_7B_pth/ggml-model-f16.bin ./zh-models/chinese_alpaca_plus_7B_pth/ggml-model-q8_0.bin 7

然後啟動

main.exe -m zh-models/chinese_alpaca_plus_7B_pth/ggml-model-q8_0.bin --color -f prompts/alpaca.txt -ins -c 2048 --temp 0.2 -n 256 --repeat_penalty 1.3

llama.cpp的響應速度非常快。差不多幾秒就回復了。但似乎回復的結果不是非常好,很多錯誤。看來這個模型的可用性還不是很高。而且回復經常中斷。